除了大型語言模型,研究人員還在開發小型語言模型(Small Language Model,SLM)。微軟發表 Phi-3 系列,語言理解、推理、數學及寫程式等能力可比大型語言模型如 GPT-3.5 Turbo,其中最少規的 Phi-3-mini 僅 38 億參數。微軟稱,設計靈感來自床邊童話,以新方式訓練模型。

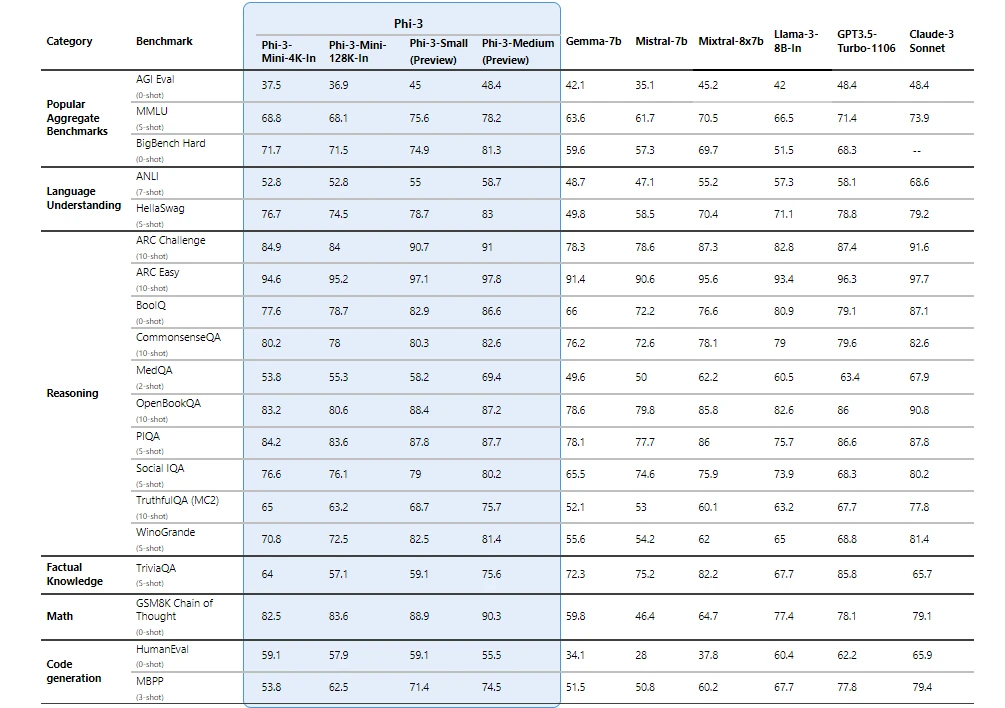

Phi-3 系列分別有 Phi-3-mini 的 38 億參數、Phi-3-small 的 70 億參數,以及 Phi-3-medium 的 140 億參數。微軟指出,Phi-3 系列雖然參數量較少,但效能卻大於參數較多的大型語言模型。微軟列出 Phi-3 系列的測試表現,評分超過 Google Gemma-7B 與 Mistral-7B,而 Phi-3-small 及 Phi-3-medium 甚至超過 Mixtral 8x7B、Claude-3 Sonnet 與 GPT-3.5 Turbo。

微軟稱,以新方式開發 Phi-3,概念源自高級研究主管 Ronen Eldan 跟女兒閱讀床邊童話。4 歲小孩如何學習詞彙?如何連結這些詞彙?以這概念作訓練模型的參考,令 SLM 能力大幅提升。

雖然 Phi-3-mini 能力比前一代 LLM 還高,但整體效能仍無法跟雲端運作的 LLM 相比,同時受限參數規模,處理即時和事實相關的知識能力亦未及。

微軟去年 6 月和 12 月分別發表 13 億參數的 Phi-1 和 27 億參數的 Phi-2。由於規模小,只能執行簡單任務,但卻可在本機運行。Phi-3-mini 具備 4K 和 128K 詞語的輸入內容,為 SLM 首度支援如此長度。

Phi-3 系列經微軟推論框架 ONNX Runtime 優化,支援 Windows DirectML,可在 CPU、GPU 或 FPGA 上運行,亦支援 NVIDIA NIM 可經 API 在 NVIDIA GPU 上運行。換言之,Phi-3 能在個人電腦的本機執行。

目前開發人員已可在 Azure AI Studio 模型庫、Hugging Face 和 Ollama 取得 Phi-3-mini,幾星期後將會開放 Phi-3-small 和 Phi-3-medium。